IOS 15.2 Nakenhetsdetektering kommer att finnas på enheten och opt-in

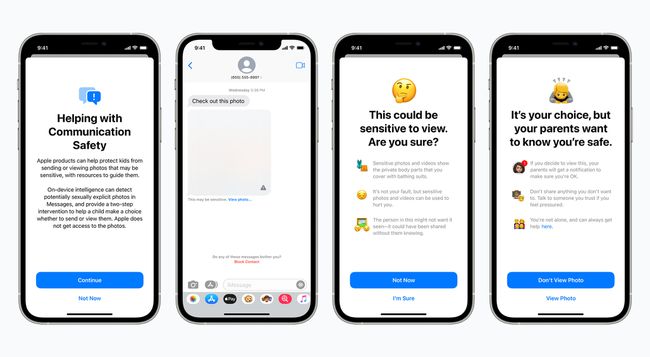

Apple kommer att driva vidare med sin nakenhetsupptäckande, barnskyddsfunktion i Messages-appen för iOS 15.2, men föräldrar måste aktivera den.

När Apple först avslöjade sina barnskyddsfunktioner möttes de av en ganska kritiskt svar, vilket resulterar i en försening av den planerade utbyggnaden. Det största integritetsproblemet – Apple skannar iCloud-foton efter material för sexuellt övergrepp mot barn (CSAM) – ligger fortfarande på is, men enligt Bloomberg, är meddelandeuppdateringen planerad att släppas med iOS 15.2. Apple säger dock att det inte kommer att vara på som standard, och att bildanalys kommer att ske på enheten, så den kommer inte att ha tillgång till potentiellt känsliga material.

RF-bilder / Getty Images

Enligt Apple, när den har aktiverats kommer funktionen att använda maskininlärning på enheten för att upptäcka om skickade eller mottagna foton i meddelanden innehåller explicit material. Detta kommer att sudda ut potentiellt explicita inkommande bilder och varna barnet eller ge dem en varning om de skickar något som kan vara explicit.

I båda fallen kommer barnet också att ha möjlighet att kontakta en förälder och berätta vad som händer. I en lista över Vanliga frågor, uppger Apple att för barnkonton 12 och yngre kommer barnet att varnas för att en förälder kommer att kontaktas om de ser/skickas explicit material. För barnkonton mellan 13-17 år varnas barnet för den potentiella risken, men föräldrar kommer inte att kontaktas.

Äpple

I samma FAQ insisterar Apple på att ingen av informationen kommer att delas med externa parter, inklusive Apple, brottsbekämpande myndigheter eller NCMEC (National Center for Missing & Exploited Children).

Dessa nya barnsäkerhetsalternativ för meddelanden bör vara tillgängliga i den kommande iOS 15.2-uppdateringen, dvs förväntas rulla någon gång denna månad, enligt Macworld.