Стручњаци кажу да нас Фацебоокова технологија Деепфаке неће спасити

- Како деепфаке постаје лакше направити, нови и побољшани начини њиховог уочавања постали су приоритет.

- Фацебоок-ова технологија за откривање дубоког лажирања користи обрнуто машинско учење да открије да ли је видео лажан или не.

- Стручњаци кажу да би коришћење блоцкцхаин технологије био најбољи начин да се види да ли је видео стваран или не, јер се метода ослања на контекстуалне податке.

Гетти Имагес

Фацебоок је сигуран у своје модел машинског учења за борбу против деепфакеса, али стручњаци кажу да нас машинско учење само по себи неће спасити од преваре дубоким лажњацима.

Компаније као што су Фацебоок, Мицрософт и Гоогле сви раде на борби против деепфакеса од ширења на вебу и друштвеним мрежама. Иако се методе разликују, постоји један потенцијално сигуран метод за уочавање ових лажних видео записа: блок ланца.

„[Блоцкцхаинс] вам само дају пуно потенцијала да потврдите деепфаке на начин који је најбољи облик валидације који могу да видим“, Степхен Волфрам, оснивач и извршни директор Волфрам Ресеарцх и аутор Нова врста науке, рекао је за Лифевире преко телефона.

Фацебоок-ова технологија Деепфаке-Споттинг

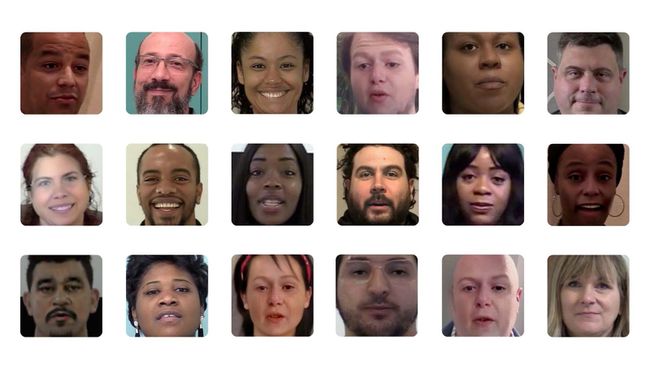

Деепфаке технологија је брзо расла у последњих неколико година. Обмањујући видео снимци користе методе машинског учења да би урадили ствари као што су преклапање нечијег лица на тело друге особе, мењање позадинских услова, лажна синхронизација усана и још много тога. Они се крећу од безазлених пародија до навођења славних или јавних личности да кажу или ураде нешто што нису.

Стручњаци кажу да технологија брзо напредује и да ће деепфакес постати убедљивији (и лакши за креирање) како технологија буде све доступнија и иновативнија.

АполитикНов / Флицкр / ЦЦ Би 2.0

Фацебоок је недавно дао више увида у своју технологију откривања деепфаке у партнерству са државним универзитетом Мичиген. Друштвена мрежа каже да се ослања на обрнути инжењеринг од једне слике генерисане вештачком интелигенцијом до генеративног модела који се користи за његову производњу.

Научници истраживања који су радили са Фејсбуком рекли су да се метода ослања на откривање јединствених образаца који стоје иза АИ модела који се користи за генерисање деепфаке-а.

„Уопштавањем атрибуције слике на препознавање отвореног скупа, можемо закључити више информација о генеративни модел који се користи за стварање деепфаке-а који превазилази препознавање да није виђен пре него што. И праћењем сличности међу обрасцима колекције дубоких лажњака, такође бисмо могли да кажемо да ли је настала серија слика из једног извора“, написали су научници истраживања Си Јин и Тан Хасснер у Фацебоок-овом блогу о његовом дубоком лажирању методом.

Фејсбук

Волфрам каже да има смисла да користите машинско учење да уочите напредни АИ модел (деепфаке). Међутим, увек постоји простор да се превари технологија.

„Уопште нисам изненађен што постоји пристојан начин машинског учења за [откривање деепфакеса]“, рекао је Волфрам. „Једино је питање, ако уложите довољно труда, можете ли га преварити? Сигуран сам да можеш.”

Борба против Деепфакеса на другачији начин

Уместо тога, Волфрам је рекао да верује да би коришћење блокчејна била најбоља опција за прецизно уочавање одређених врста деепфаке-а. Његово мишљење о коришћењу блокчејна у односу на машинско учење датира још из 2019. године и рекао је да, на крају крајева, приступ блокчејна може да пружи прецизније решење за наш проблем дубоког лажирања.

„Очекивао бих да би гледаоци слика и видео снимака могли рутински да проверавају у односу на блок ланце (и 'триангулацију података цомпутатионс') помало налик на то како веб прегледачи сада проверавају безбедносне сертификате“, написао је Волфрам у чланку објављено у часопису Сциентифиц Америцан.

Пошто ланци блокова чувају податке у блоковима који се затим повезују заједно хронолошким редом, и пошто су децентрализовани ланци блокова непроменљиви, унети подаци су неповратни.

„Једино је питање ако уложите довољно труда, можете ли га преварити? Сигуран сам да можеш."

Волфрам је објаснио да ћете стављањем видеа у блок ланац моћи да видите време снимања, локацију и друге контекстуалне информације које би вам омогућиле да кажете да ли је било измењено начин.

„Уопштено говорећи, што више метаподатака постоји који контекстуализују слику или видео, већа је вероватноћа да ћете то моћи да кажете“, рекао је он. „Не можете лажирати време на блокчејну.“

Међутим, Волфрам је рекао да коришћени метод - било да се ради о машинском учењу или коришћењу блокчејна - зависи од врсте деепфаке-а који покушавате за заштиту од (тј. видео снимка Ким Кардашијан како говори нешто глупо или видео снимка политичара који даје изјаву или предлог).

„Блокчејн приступ штити од одређених врста дубоких лажирања, баш као што обрада слика машинским учењем штити од одређених врста дубоких лажирања“, рекао је он.

Суштина је, чини се, будност свих нас када је у питању борба против надолазеће лажне поплаве.