TensorRT-LLM aduce calculul AI local pe GPU-urile NVIDIA

Ce trebuie sa stii

- TensorRT-LLM adaugă suportul OpenAI Chat API pentru desktop-uri și laptop-uri cu GPU-uri RTX începând de la 8 GB de VRAM.

- Utilizatorii pot procesa interogările LLM mai rapid și local, fără a încărca seturi de date în cloud.

- NVIDIA combină acest lucru cu „Retrieval-Augmented Generation” (RAG), permițând mai multe cazuri de utilizare LLM personalizate.

În timpul conferinței Microsoft Ignite de astăzi, NVIDIA a anunțat o actualizare a TensorRT-LLM, care lansat in octombrie. Principalele anunțuri de astăzi sunt că caracteristica TensorRT-LLM câștigă acum suport pentru API-urile LLM, în special API-ul OpenAI Chat, care este cel mai bine-cunoscut în acest moment și, de asemenea, că au lucrat pentru a îmbunătăți performanța cu TensorRT-LLM pentru a obține o performanță mai bună pe token pe GPU-urile lor.

Există un anunț terțiar care este, de asemenea, destul de interesant. NVIDIA va include Retrieval-Augmented Generation cu TensorRT-LLM. Acest lucru permite unui LLM să utilizeze o sursă de date externă pentru baza sa de cunoștințe, mai degrabă decât să se bazeze pe ceva online - o caracteristică foarte solicitată pentru AI.

Ce este TensorRT-LLM?

CITEȘTE MAI MULTE DE LA IGNITE 2023

- Microsoft își produce propriile cipuri Arm

- Copilot vine pe tot Microsoft 365

- Bing Chat a redenumit Copilot

- Microsoft Loop acum disponibil în general

- Microsoft Mesh și spații imersive

- Microsoft Planner îmbină To Do și Project

- Microsoft lansează Copilot Studio

- Microsoft Security Copilot

- Aplicația web Copilot este disponibilă

NVIDIA a lansat recent NVIDIA TensorRT-LLM, o bibliotecă open-source care permite calcularea locală a LLM-urilor pe hardware-ul NVIDIA. NVIDIA promovează acest lucru pentru a câștiga confidențialitate și eficiență atunci când are de-a face cu seturi mari de date sau informații private. Dacă aceste informații sunt trimise printr-un API precum API-ul de chat al OpenAI, este sigur. Puteți afla mai multe despre NVIDIA TensorRT-LLM la Site-ul pentru dezvoltatori NVIDIA.

Modificările anunțate astăzi la NVIDIA TensorRT-LLM sunt adăugarea API-ului de chat OpenAI și a performanței îmbunătățiri pentru modelele LLM și AI acceptate anterior, cum ar fi Llama 2 și Stable Diffusion prin DirectML îmbunătățiri.

Această tehnologie și calcul pot fi realizate local prin Bancul de lucru AI NVIDIA. Acest „set de instrumente unificat, ușor de utilizat, permite dezvoltatorilor să creeze, să testeze și să personalizeze rapid modele AI generative pre-antrenate și LLM-uri pe un computer sau pe o stație de lucru”. NVIDIA are un pagina de înscriere cu acces anticipat pentru cei interesați să-l folosească.

NVIDIA TensorRT-LLM este o bibliotecă open-source care accelerează și optimizează performanța de inferență a celor mai recente modele de limbaj mari (LLM) pe platforma NVIDIA AI

NVIDIA

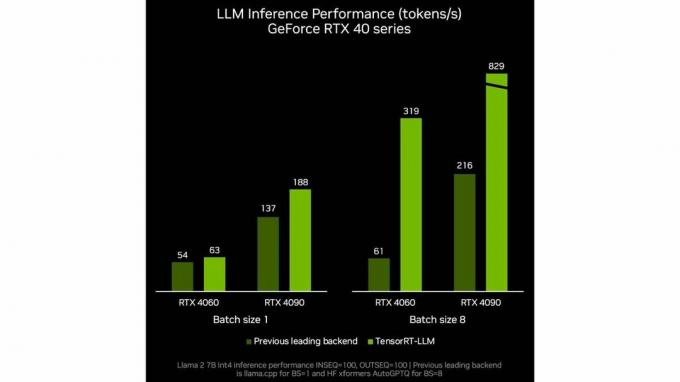

Nvidia arată, de asemenea, o îmbunătățire a performanței pe token pentru LLM, așa cum putem vedea în aceste benchmark-uri interne NVIDIA. Ca întotdeauna, aveți grijă la benchmark-urile producătorilor și la testarea pentru raportarea exactă a câștigului de performanță.

Acum că știm TensorRT-LLM de la NVIDIA, de ce este acest lucru special sau util? În cea mai mare parte, rularea locală pe o stație de lucru sau un computer alimentat de NVIDIA va duce probabil la aceleași răspunsuri la întrebări, deși probabil într-un ritm mai lent din cauza lipsei puterii de calcul în cloud.

Imaginea NVIDIA pentru acest caz de utilizare vine împreună atunci când discutăm despre celălalt anunț de astăzi NVIDIA, și anume integrarea cu o nouă tehnologie sau caracteristică numită Retrieval-Augmented Generaţie.

Ce este Retrieval-Augmented Generation

Termenul de recuperare-generație augmentată a fost inventat în a hârtie de o serie de autori, autorul principal fiind Patrick Lewis. Este numele adoptat de industrie pentru o soluție la o problemă pe care toți cei care au folosit un LLM au întâlnit-o. Depășite sau informații care sunt corecte, dar eronate în contextul discuției. Detaliile aprofundate despre cum funcționează RAG pot fi găsite într-unul dintre NVIDIA Rezumate tehnice.

Generarea îmbunătățită prin recuperare este o tehnică pentru îmbunătățirea acurateței și fiabilității modelelor AI generative cu fapte preluate din surse externe.

Rick Merritt

Prin împerecherea generației îmbunătățite de recuperare cu TensorRT-LLM de la NVIDIA, utilizatorii finali pot personaliza informațiile la care are acces LLM atunci când își execută interogările. ChatGPT a anunțat recent GPT-uri personalizate care ar putea oferi rezultate similare.

După cum sa discutat în articolul nostru despre GPT-uri personalizate, capacitatea de a crea instanțe LLM personalizate, cu un singur scop, fie cu un GPT personalizat, fie, în acest caz, cu o instanță LLM care, folosind generație sporită de recuperare, are acces doar la toate lucrările publicate ale lui Charles Dickens și nimic altceva, ar putea ajuta la crearea de LLM-uri concepute special, semnificative și precise pentru diferite cazuri de utilizare.

Va fi util TensorRT-LLM?

Ce înseamnă toate acestea împreună? Există câteva oportunități reale pentru ca acest lucru să fie folosit în mod semnificativ. Cât de ușor va fi de implementat sau cât de sigure vor fi datele? Numai timpul va spune. Există un potențial de îmbunătățire a AI, în special la nivel de întreprindere fluxuri de lucru, oferă acces mai convenabil la informații complicate și ajută angajații în acest sens sarcini provocatoare.

Chiar dacă aceste sarcini vor fi executate local, ele vor trece în continuare prin API-urile LLM normale, care se vor confrunta cu aceleași restricții și limitări de conținut ca acum. Cu toate acestea, deoarece tehnologii precum TensorRT-LLM de la NVIDIA fac mai rapidă utilizarea unui LLM offline, cineva l-ar putea integra cu ceva de genul EvilGPT, care nu are limitări în ceea ce privește conduita sa și este utilizat în prezent pentru a crea malware și a asista în atacurile cibernetice, potențialul ca un AI să producă unele daune reale doar se amplifică.

Ce părere aveți despre actualizările NVIDIA la TensorRT-LLM? Vă puteți gândi la vreo utilizare pentru el pe care mi le-a ratat? Spune-ne în comentarii.