Door ChatGPT gegenereerde tekst kan nu 99% van de tijd worden geïdentificeerd

Wat je moet weten

- Een onderzoeksteam staat op het punt van een doorbraak met een AI Detector-tool die door ChatGPT gegenereerde tekst kan identificeren en een nauwkeurigheid van 99% belooft.

- De onderzoekers hebben de tool aan verschillende tests onderworpen, waaronder het gebruik ervan om door AI gegenereerde tekst te onderscheiden van menselijke inhoud.

- De resultaten waren indrukwekkend, maar de tool classificeerde een aantal documenten ten onrechte als door AI gegenereerd, terwijl ze in werkelijkheid door mensen waren geschreven.

- De onderzoekers gebruikten XGBoost voor alle experimenten en tests, die afhankelijk waren van het R-pakket, xGBoost, dat een geavanceerde manier bood om modeloptimalisatie te meten.

De opkomst van generatieve AI en, met name, ChatGPT heeft ongelooflijke kansen voortgebracht, waardoor gebruikers onbenut potentieel kunnen verkennen, maar het heeft ook zijn tegenslagen in gelijke mate. Veiligheid en privacy van AI zijn enkele van de grootste zorgen onder gebruikers, waardoor de technologie zijn volledige potentieel niet kan realiseren. Echter,

Authenticiteit en nauwkeurigheid maken ook deel uit van deze zorgen. Als de recente rapporten dat citeren ChatGPT wordt dommer En nauwkeurigheid verliezen Als er iets is waar we op kunnen vertrouwen, dan zijn deze zorgen terecht. Tot nu toe is er geen brandveilige laan die kunnen worden onderzocht om door AI gegenereerde tekst met ongekende nauwkeurigheid te detecteren.

Gelukkig staat een groep onderzoekers op de rand van een doorbraak het is gemakkelijker om door AI gegenereerde tekst te identificeren. Met aanzienlijke updates die worden verzonden naar AI-aangedreven chatbots zoals Bing-chat En ChatGPT zo nu en dan wordt het steeds moeilijker om tekst die met deze tools is gegenereerd te demystificeren van menselijke tekst.

Volgens het rapportis de AI-detector ontworpen om door AI gegenereerde tekst in wetenschappelijke tijdschriften te detecteren. Het uitvoeren van tests op dit soort tijdschriften is een serieuze onderneming, afhankelijk van de complexiteit van het onderwerp en de beschikbaarheid van de informatie op internet.

Volgens de onderzoekers werd de AI-detector gebruikt om menselijke schrijvers te onderscheiden van ChatGPT (GPT-3.5). Ze onthulden verder dat de methodologie afhankelijk was van twintig functies en een machine learning-algoritme, dat geen 'verbijstering'-maatstaf bevatte. Dit komt omdat ze het classificeerden als een ‘problematische maatstaf’, die in andere tools vooroordelen zou introduceren tegenover niet-moedertaalsprekers van het Engels.

Bovendien demonstreert het model een nauwkeurigheid van 99% bij het onderscheiden van menselijk schrift en teksten geproduceerd door ChatGPT. presteert aanzienlijk beter dan de GPT-2 Output Detector, AI-detectiesoftware die werd aangeboden door OpenAI, makers van ChatGPT.

AI-detectoronderzoekers

Dat hebben wij onlangs vernomen OpenAI aan het werken was een nieuwe tool waarmee gebruikers door AI gegenereerde afbeeldingen kunnen identificeren. Het bedrijf beloofde een nauwkeurigheid van 99 procent, hoewel het nog niet duidelijk is wanneer het breed beschikbaar zal zijn.

De onderzoekers geven toe dat de reikwijdte van het oorspronkelijke werk beperkt was, omdat ze slechts één type prompt uit één tijdschrift testten. Bovendien was het niet uitsluitend een scheikundetijdschrift, om nog maar te zwijgen van het feit dat er slechts één taalmodel werd getest.

Volgens de onderzoekers:

"... we breiden de toepasselijke reikwijdte van onze onlangs beschreven AI-detector radicaal uit door deze toe te passen op nieuwe omstandigheden met variabiliteit bij mensen schrijven, waaronder uit 13 verschillende tijdschriften en 3 verschillende uitgevers, variabiliteit in AI-prompts en variabiliteit in het AI-tekstgeneratiemodel gebruikt. Met behulp van dezelfde 20 functies als eerder beschreven, trainen we een XGBoost-classificator met voorbeeldteksten van menselijke teksten en vergelijkende AI-tekst. Vervolgens beoordelen we het model door nieuwe voorbeelden van menselijk schrijven, meerdere uitdagende AI-prompts en zowel GPT-3.5 als GPT-4 te gebruiken om de AI-tekst te produceren."

De AI-detector belooft een nauwkeurigheid van 99%

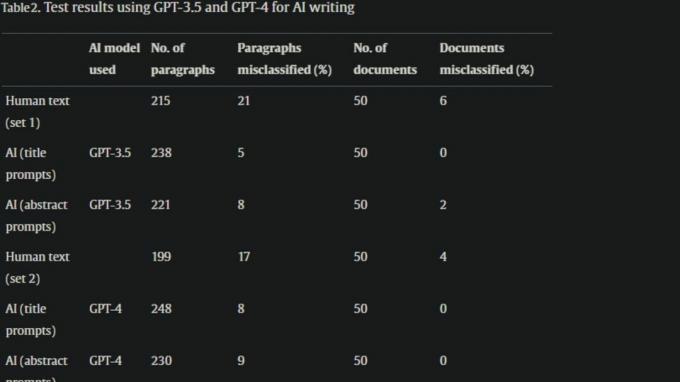

De onderzoekers gaven aan dat de tests aantoonden dat hun methodologie eenvoudig en effectief was. Ze benadrukten dat de tool een nauwkeurigheid van 98% tot 100% vertoonde bij het identificeren van door AI gegenereerde tekst, maar dit was afhankelijk van de prompt en het model.

De onderzoekers gaven aan dat de tool mijlenver voorloopt op de bijgewerkte classificatie van OpenAI, die qua nauwkeurigheid tussen 10% en 56% ligt. De onderzoekers onthulden verder dat het doel achter deze studie en uitvinding is om de wetenschappelijke gemeenschap een mogelijkheid te bieden die dit mogelijk maakt "de infiltratie van ChatGPT in scheikundige tijdschriften beoordelen, de gevolgen van het gebruik ervan identificeren en snel mitigatiestrategieën introduceren wanneer problemen optreden" ontstaan.”

Wat gebruikten de onderzoekers als classificator voor tests?

De onderzoekers gebruikten XGBoost voor alle experimenten en tests, die afhankelijk waren van het R-pakket, xgboost. Het bood een geavanceerde manier om de optimalisatie van modellen te meten, omdat de nauwkeurigheid op paragraafniveau werd gemeten met behulp van 'leave-one-introduction-out'-kruisvalidatie op de trainingsset.

Het onderzoeksteam verklaarde dat:

"In dit paradigma zouden alle trainingsgegevens, behalve die afkomstig uit de paragrafen van de inleiding die moeten worden geclassificeerd, worden gebruikt om een classificatiemodel te bouwen. Dit model zou dan worden gebruikt om alle paragrafen uit de weggelaten inleiding te classificeren."

Het onderzoek benadrukt dat deze omstandigheden "de beste algehele nauwkeurigheid op paragraafniveau opleverden", die vervolgens in alle tests werd gebruikt.

Zijn de resultaten veelbelovend?

Toegegeven, de AI Detector boekte indrukwekkende resultaten, maar er is ruimte voor verbetering. De technologie is relatief nieuw, dus er was een foutmarge verwacht. Maar toch doet het verkeerd classificeren van 6% van de geteste menselijke tekst de wenkbrauwen fronsen.

Reddit-gebruikers in de r/science-subreddit terechte zorgen over deze kwestie uiten. Een bezorgde gebruiker presenteerde een hypothetische situatie waarin deze tool op school werd gebruikt en verklaarde dat de resultaten geven aan dat van elke 100 studenten er 6 valselijk beschuldigd zouden worden van het gebruik van AI-aangedreven tools om hun doelen te bereiken. cursussen. En we kennen allemaal de aanzienlijke tegenslagen die gepaard gaan met het indienen van werk dat je ergens anders vandaan hebt gehaald.

Dit bewijst het belang van betrouwbare en nauwkeurige tools zoals AI Detector, maar tegelijkertijd is het bijna onmogelijk om de nauwkeurigheid van deze tools te garanderen. Een andere gebruiker presenteerde een geval waarin een cursusbegeleider een opdracht had gemarkeerd als door AI gegenereerd. Nadat dit onderzoek met de docent was gedeeld en zelfs de tool was gebruikt om de syllabus door te nemen, werd het echter gemarkeerd als door AI gegenereerde inhoud.

Hoewel dit een heel gladde scheerbeurt was, Wat gebeurt er als u uw claims niet kunt onderbouwen? Denkt u dat het een punt zal bereiken waarop AI-detectoren absolute nauwkeurigheid kunnen beloven? Deel uw mening met ons in de reacties.