Eksperti saka, ka Facebook Deepfake Tech mūs neglābs

- Tā kā dziļo viltojumu izgatavošana kļūst vieglāka, par prioritāti ir kļuvuši jauni un uzlaboti to pamanīšanas veidi.

- Facebook dziļās viltojumu noteikšanas tehnoloģija izmanto reverso mašīnmācīšanos, lai atklātu, vai videoklips ir viltots vai nē.

- Eksperti saka, ka blokķēdes tehnoloģijas izmantošana būtu labākais veids, kā noskaidrot, vai videoklips ir īsts, jo metode balstās uz kontekstuālajiem datiem.

Getty Images

Facebook ir pārliecināts par to mašīnmācīšanās modelis dziļo viltojumu apkarošanai, taču eksperti saka, ka mašīnmācība pati par sevi nepasargās mūs no dziļo viltojumu maldināšanas.

Uzņēmumi, piemēram, Facebook, Microsoft un Google visi strādā, lai apkarotu dziļos viltojumus no izplatīšanās tīmeklī un sociālajos tīklos. Lai gan metodes atšķiras, ir viena iespējama droša metode, kā atklāt šos viltus videoklipus: blokķēdes.

"[Blockchains] vienkārši sniedz jums daudz iespēju apstiprināt dziļo viltojumu tādā veidā, kas ir labākais apstiprināšanas veids, ko es varu redzēt," Stīvens Volframs, uzņēmuma dibinātājs un izpilddirektors.

Facebook Deepfake-Spotting Tech

Deepfake tehnoloģija pēdējos gados ir strauji attīstījusies. Maldinošajos videoklipos tiek izmantotas mašīnmācīšanās metodes, lai veiktu tādas darbības kā, piemēram, sejas uzklāšana uz citas personas ķermeņa, fona apstākļu maiņa, viltus lūpu sinhronizācija un citas darbības. Tās svārstās no nekaitīgām parodijām līdz slavenībām vai sabiedrībā zināmām personām teikt vai darīt kaut ko tādu, ko viņi nav izdarījuši.

Eksperti saka, ka tehnoloģija attīstās ātri un dziļi viltojumi kļūs tikai pārliecinošāki (un vieglāk izveidojami), jo tehnoloģija kļūs plašāk pieejama un novatoriskāka.

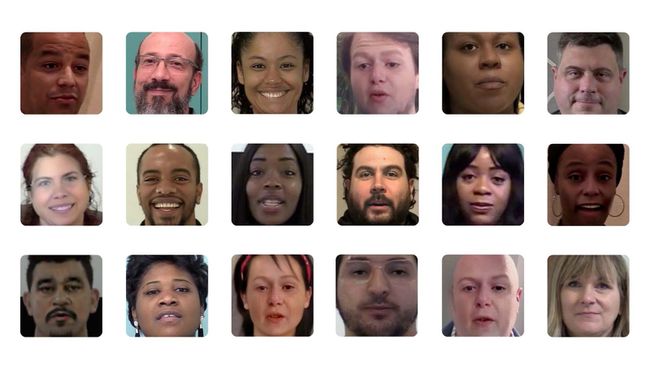

ApolitikNow / Flickr / CC By 2.0

Facebook nesen sadarbībā ar Mičiganas štata universitāti sniedza plašāku ieskatu savā dziļās viltojumu noteikšanas tehnoloģijā. Sociālais tīkls saka, ka tas balstās uz reverso inženieriju, sākot no viena mākslīgā intelekta ģenerēta attēla līdz ģeneratīvajam modelim, ko izmanto tā izgatavošanai.

Zinātnieki, kas strādāja ar Facebook, teica, ka šī metode balstās uz unikālo modeļu atklāšanu aiz mākslīgā intelekta modeļa, ko izmanto, lai radītu dziļu viltojumu.

“Vispārinot attēla attiecināšanu uz atvērto atpazīšanu, mēs varam iegūt vairāk informācijas par ģeneratīvais modelis, ko izmanto, lai izveidotu dziļu viltojumu, kas pārsniedz atpazīšanu, ka tas nav redzēts pirms tam. Un, izsekojot līdzības dziļo viltojumu kolekcijas modeļos, mēs varētu arī noteikt, vai attēlu sērija ir radusies no viena avota,” Facebook emuāra ierakstā par tā dziļo viltus pamanīšanu rakstīja pētnieki Sji Iņ un Tans Hasners. metodi.

Volframs saka, ka ir loģiski, ka jūs izmantotu mašīnmācīšanos, lai pamanītu uzlabotu AI modeli (dziļa viltojumu). Tomēr vienmēr ir iespēja apmānīt tehnoloģiju.

"Es nemaz neesmu pārsteigts, ka pastāv pienācīgs mašīnmācīšanās veids [atklāt dziļos viltojumus]," sacīja Volframs. "Vienīgais jautājums ir, ja jūs pieliekat pietiekami daudz pūļu, vai varat to apmānīt? Esmu pārliecināts, ka jūs varat."

Cīņa ar dziļo viltojumu citādāk

Tā vietā Volframs sacīja, ka, viņaprāt, blokķēdes izmantošana būtu labākais risinājums, lai precīzi noteiktu noteiktu veidu dziļos viltojumus. Viņa viedoklis par blokķēdes izmantošanu mašīnmācīšanās vietā sniedzas 2019. gadā, un viņš teica, ka galu galā blokķēdes pieeja var nodrošināt precīzāku mūsu dziļās viltošanas problēmas risinājumu.

"Es ceru, ka attēlu un video skatītāji varētu regulāri pārbaudīt blokķēdes (un" datu triangulāciju aprēķini") mazliet līdzīgi tam, kā tīmekļa pārlūkprogrammas tagad pārbauda drošības sertifikātus," rakstā rakstīja Volframs publicēts žurnālā Scientific American.

Tā kā blokķēdes glabā datus blokos, kas pēc tam tiek savienoti kopā hronoloģiskā secībā, un tā kā decentralizētās blokķēdes ir nemainīgas, ievadītie dati ir neatgriezeniski.

"Vienīgais jautājums ir, ja jūs pieliekat pietiekami daudz pūļu, vai varat to apmānīt? Esmu pārliecināts, ka jūs varat."

Volframs paskaidroja, ka, ievietojot videoklipu blokķēdē, jūs varēsit redzēt laiku, kāds tas tika aizņemts, atrašanās vieta un cita kontekstuāla informācija, kas ļautu noteikt, vai tā ir mainīta veidā.

"Kopumā, ja ir vairāk metadatu, kas kontekstualizē attēlu vai videoklipu, jo lielāka iespēja, ka jūs varēsit to pateikt," viņš teica. "Jūs nevarat viltot laiku blokķēdē."

Tomēr Volframs teica, ka izmantotā metode — vai tā ir mašīnmācīšanās vai blokķēdes izmantošana — ir atkarīga no dziļās viltošanas veida, kuru mēģināt. lai aizsargātos pret (t.i., video, kurā Kima Kardašjana saka kaut ko muļķīgu, vai video, kurā politiķe sniedz paziņojumu vai ieteikums).

"Bloku ķēdes pieeja aizsargā pret noteikta veida dziļiem viltojumiem, tāpat kā mašīnmācīšanās attēlu apstrāde aizsargā pret noteikta veida dziļiem viltojumiem," viņš teica.

Šķiet, ka galvenais ir mūsu visu modrība, kad runa ir par cīņu pret gaidāmajiem dziļajiem plūdiem.