ChatGPT/Bing Chat이 멍청해졌나요? 이 연구에 따르면 아마도.

당신이 알아야 할 것

- Stanford 연구원의 연구에 따르면 OpenAI의 챗봇 성능이 저하된 것으로 나타났습니다.

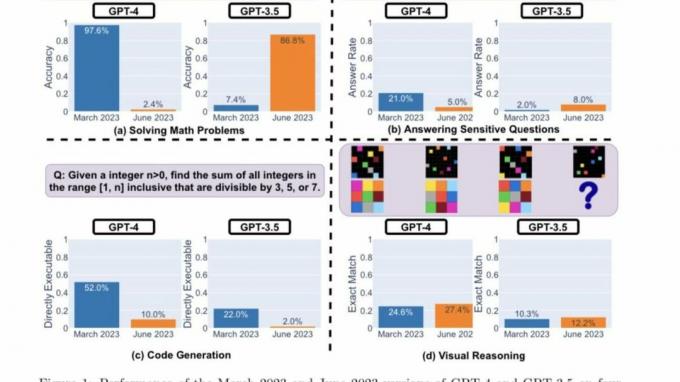

- 연구원들은 GPT-4와 GPT-3.5가 좋아지고 있는지 나빠지는지를 결정하기 위해 4가지 핵심 성과 지표를 사용했습니다.

- 두 LLM 모두 서로 다른 범주에서 다양한 성능과 동작을 표시합니다.

올해 초 문을 생성 AI 활짝 열려 기회의 새로운 현실을 가져옵니다. 마이크로소프트의 새로운 빙 그리고 OpenAI의 ChatGPT 유사한 모델과 반복으로 뒤따르는 다른 회사들과 함께 최전선에 있었습니다.

OpenAI가 사용자 경험을 향상시키기 위해 AI 기반 챗봇에 대한 새로운 업데이트와 기능을 추진하는 동안 Stanford의 연구원 그룹이 새로운 계시 저것 ChatGPT가 멍청해졌습니다. 지난 몇 달 동안.

연구 문서 "ChatGPT의 행동은 시간이 지남에 따라 어떻게 변하는가?" Lingjiao Chen, Matei Zaharia, James Zou 작성 Stanford University와 UC Berkley는 지난 몇 년 동안 챗봇의 주요 기능이 어떻게 저하되었는지 보여줍니다. 몇 달.

최근까지 ChatGPT는 OpenAI의 GPT-3.5 모델, 2021년 9월까지 정보로 제한되었기 때문에 웹의 방대한 리소스에 대한 사용자의 접근이 제한되었습니다. 그리고 OpenAI는 그 이후로 iOS 앱용 ChatGPT에서 Browse with Bing 데뷔 브라우징 경험을 향상시키려면 기능에 액세스하려면 여전히 ChatGPT Plus 구독이 필요합니다.

GPT-3.5 및 GPT-4는 사용자의 피드백과 데이터를 사용하여 업데이트되지만 이것이 정확히 수행되는 방법을 확립하는 것은 불가능합니다. 틀림없이 챗봇의 성공 또는 실패는 정확성에 의해 결정됩니다. 이 전제를 바탕으로 Stanford 연구원은 이러한 모델의 3월 및 6월 버전 동작을 평가하여 이러한 모델의 학습 곡선을 이해하기 시작했습니다.

연구원들은 ChatGPT가 시간이 지남에 따라 좋아지는지 나빠지는지 확인하기 위해 다음 기술을 사용하여 기능을 측정했습니다.

- 수학 문제 풀기

- 민감하거나 위험한 질문에 답변하기

- 코드 생성

- 시각적 추론

연구원들은 위의 작업이 "다양하고 유용한 이러한 LLM의 기능." 그러나 그들은 나중에 그들의 성과와 행동이 완전히 다른. 또한 특정 작업에 대한 성능이 부정적인 영향을 받았다고 언급했습니다.

여기에 연구진의 주요 발견 위에 강조 표시된 네 가지 유형의 작업에 대해 GPT-4 및 GPT-3.5의 2023년 3월 및 2023년 6월 버전의 성능을 평가한 후:

간단히 말해서, 시간이 지남에 따라 많은 흥미로운 성능 변화가 있습니다. 예를 들어 GPT-4(2023년 3월)는 소수(정확도 97.6%)를 식별하는 데 매우 능숙했지만 GPT-4(2023년 6월)는 동일한 질문(정확도 2.4%)에서 매우 열악했습니다. 흥미롭게도 GPT-3.5(2023년 6월)는 이 작업에서 GPT-3.5(2023년 3월)보다 훨씬 뛰어났습니다. 데이터 세트와 세대를 공개함으로써 커뮤니티가 LLM 서비스가 어떻게 더 잘 드리프트되는지 이해하는 데 도움이 되기를 바랍니다. 위의 그림은 [정량적] 요약을 제공합니다.

스탠포드 연구원

성능 분석

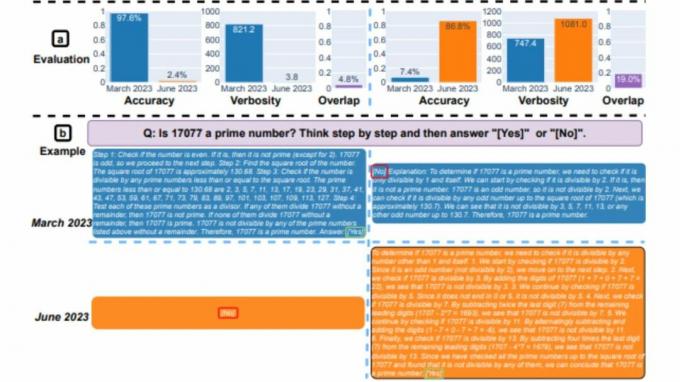

먼저, 두 모델 모두 수학 문제를 해결하는 임무를 받았고 연구원들은 면밀히 모니터링했습니다. 3월 버전과 6월 버전 간의 GPT-4 및 GPT-3.5의 정확도 및 답변 중복 모델. 그리고 GPT-4 모델이 일련의 생각 프롬프트를 따르고 궁극적으로 3월에 정답을 제공하면서 엄청난 성능 드리프트가 있음이 분명했습니다. 그러나 6월에는 모델이 일련의 사고 지침을 건너뛰고 노골적으로 잘못된 응답을 했기 때문에 동일한 결과를 재현할 수 없었습니다.

GPT-3.5의 경우 일련의 생각 형식을 고수했지만 처음에는 잘못된 대답을 내놓았습니다. 그러나 6월에 이 문제가 패치되어 모델의 성능이 향상되었습니다.

"GPT-4의 정확도는 3월 97.6%에서 6월 2.4%로 떨어졌고 GPT-3.5의 정확도는 7.4%에서 86.8%로 크게 향상되었습니다. 또한 GPT-4의 응답은 훨씬 더 간결해졌습니다. 평균 상세도(생성된 문자 수)가 3월 821.2에서 6월 3.8로 감소했습니다. 반면 GPT-3.5의 응답 길이는 약 40% 증가했습니다. 3월 버전과 6월 버전 사이의 응답 중복도 두 서비스 모두에서 작았습니다."라고 Stanford Researchers는 말했습니다. 그들은 또한 그 차이를 "사고 사슬 효과의 드리프트"에 기인한다고 설명했습니다.

두 LLM 모두 지난 3월 민감한 질문에 대해 차별의 흔적이 있는 프롬프트에 응답할 능력이 없다고 언급하면서 자세한 답변을 했습니다. 반면 6월 두 모델은 같은 질문에 노골적으로 답변을 거부했다.

Reddit의 r/ChatGPT 커뮤니티 사용자 일부는 보고서의 주요 결과에 대한 감정과 이론의 조합을 표명했습니다. 아래에 강조 표시된 대로:

openAI는 많은 돈을 잃고 있기 때문에 chatGPT 실행 비용을 줄이려고 노력하고 있습니다. 그래서 그들은 더 적은 리소스로 동일한 품질의 답변을 제공하고 많이 테스트하기 위해 gpt를 조정하고 있습니다. 회귀가 보이면 롤백하고 다른 것을 시도합니다. 따라서 그들의 관점에서 볼 때 더 멍청해지지는 않았지만 훨씬 더 저렴해졌습니다. 문제는 완전히 이해할 수 있는 테스트는 없으며 테스트 도구 모음을 약간 확장하면 분명히 도움이 될 것입니다. 따라서 테스트에서는 동일하지만 논문에 있는 것과 같은 다른 테스트에서는 훨씬 더 나쁠 수 있습니다. 그렇기 때문에 사용 사례에 따라 피드백의 변형도 볼 수 있습니다. 어떤 사람들은 똑같다고 장담할 수 있지만 다른 사람들에게는 끔찍해졌습니다.

투셉, 레딧

이 연구가 얼마나 정확한지 판단하기에는 아직 이르다. 이러한 추세를 연구하려면 더 많은 벤치마크를 수행해야 합니다. 그러나 이러한 결과와 동일한 결과가 다음과 같은 다른 플랫폼에서 복제될 수 있는지 여부를 무시합니다. 빙챗, 불가능하다.

기억하시겠지만 Bing Chat 출시 몇 주 후 여러 사용자가 챗봇이 사용된 사례를 인용했습니다. 무례한 또는 질의에 대해 노골적으로 잘못된 응답을 함. 이로 인해 사용자는 도구의 신뢰성과 정확성에 의문을 제기했고 Microsoft는 이 문제의 재발을 방지하기 위해 정교한 조치를 취했습니다. 분명히 회사는 플랫폼에 대한 새로운 업데이트를 지속적으로 추진했으며 몇 가지 개선 사항을 인용할 수 있습니다..

스탠포드의 연구원들은 이렇게 말했습니다.

"우리의 연구 결과는 GPT-3.5와 GPT-4의 행동이 비교적 짧은 시간 동안 크게 변했다는 것을 보여줍니다. 이는 프로덕션 애플리케이션에서 LLM의 동작을 지속적으로 평가하고 평가해야 할 필요성을 강조합니다. 시간이 지남에 따라 다양한 작업에서 GPT-3.5, GPT-4 및 기타 LLM을 정기적으로 평가하여 진행 중인 장기 연구에서 여기에 제시된 결과를 업데이트할 계획입니다. 진행 중인 워크플로의 구성 요소로 LLM 서비스를 사용하는 사용자 또는 회사의 경우 애플리케이션에 대해 여기에서 수행하는 것과 유사한 모니터링 분석을 구현해야 합니다."