ფეისბუქის Deepfake Tech არ გადაგვარჩენს, ამბობენ ექსპერტები

- როდესაც ღრმა ფეიქი უფრო ადვილი ხდება, მათი აღმოჩენის ახალი და გაუმჯობესებული გზები პრიორიტეტად იქცა.

- ფეისბუქის ღრმა სიყალბის დაფიქსირების ტექნოლოგია იყენებს საპირისპირო მანქანურ სწავლებას, რათა აღმოაჩინოს, არის თუ არა ვიდეო ღრმა Fake.

- ექსპერტები ამბობენ, რომ ბლოკჩეინის ტექნოლოგიის გამოყენება საუკეთესო გზა იქნება იმის დასანახად, არის თუ არა ვიდეო რეალური თუ არა, რადგან მეთოდი ეყრდნობა კონტექსტურ მონაცემებს.

გეტის სურათები

Facebook დარწმუნებულია ამაში მანქანათმცოდნეობის მოდელი ღრმა ფეიქებთან საბრძოლველად, მაგრამ ექსპერტები ამბობენ, რომ მანქანათმცოდნეობა თავისთავად არ გვიხსნის ღრმა ფეიქების მოტყუებისგან.

კომპანიები, როგორიცაა Facebook, Microsoft და Google ყველა მუშაობს ღრმა ფეიქებთან საბრძოლველად ინტერნეტში და სოციალურ ქსელებში გავრცელებისგან. მიუხედავად იმისა, რომ მეთოდები განსხვავებულია, არსებობს ერთი პოტენციური უგუნური მეთოდი ამ ყალბი ვიდეოების დასანახად: ბლოკჩეინები.

”[ბლოკჩეინები] უბრალოდ გაძლევენ უამრავ პოტენციალს, რომ დაადასტუროთ ღრმა ფეიქი ისე, რომ ეს არის დადასტურების საუკეთესო ფორმა, რაც მე შემიძლია ვნახო,” სტივენ ვოლფრამი, დამფუძნებელი და აღმასრულებელი დირექტორი.

Facebook-ის Deepfake-Spotting Tech

Deepfake ტექნოლოგია სწრაფად გაიზარდა ბოლო რამდენიმე წლის განმავლობაში. შეცდომაში შემყვანი ვიდეოები იყენებს მანქანური სწავლის მეთოდებს ისეთი მოქმედებების გასაკეთებლად, როგორიცაა სხვისი სახის სხვა ადამიანის სხეულზე გადატანა, ფონის პირობების შეცვლა, ყალბი ტუჩის სინქრონიზაცია და სხვა. ისინი მერყეობს უვნებელი პაროდიებიდან დაწყებული, ცნობილი ადამიანების ან საზოგადო მოღვაწეების თქმის ან იმის გაკეთებამდე, რაც არ გააკეთეს.

ექსპერტები ამბობენ, რომ ტექნოლოგია სწრაფად მიიწევს წინ და რომ ღრმა ფეიქი უფრო დამაჯერებელი გახდება (და უფრო ადვილია შექმნა), რადგან ტექნოლოგია უფრო ფართოდ ხელმისაწვდომი და ინოვაციური გახდება.

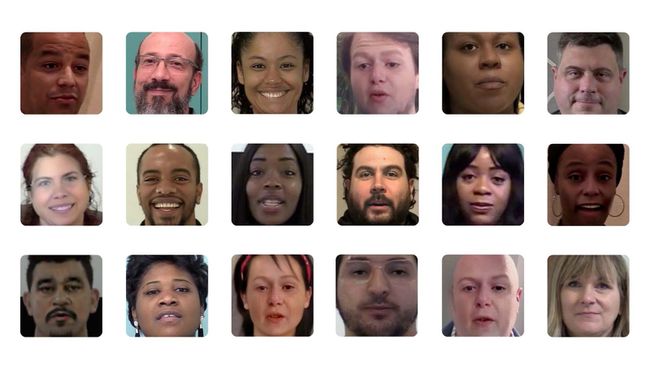

ApolitikNow / Flickr / CC By 2.0

ფეისბუქმა ცოტა ხნის წინ მიჩიგანის სახელმწიფო უნივერსიტეტთან თანამშრომლობით უფრო მეტი ინფორმაცია მისცა ღრმა ყალბი აღმოჩენის ტექნოლოგიას. სოციალური ქსელი ამბობს, რომ ის ეყრდნობა უკუ ინჟინერიას ერთი ხელოვნური ინტელექტის მიერ გენერირებული სურათიდან მის წარმოებისთვის გამოყენებულ გენერაციულ მოდელამდე.

მკვლევარებმა, რომლებიც მუშაობდნენ ფეისბუქთან, განაცხადეს, რომ მეთოდი ეყრდნობა ხელოვნური ინტელექტის მოდელის უნიკალური შაბლონების აღმოჩენას, რომელიც გამოიყენება ღრმა ფეიკის შესაქმნელად.

„ღია ნაკრების ამოცნობაზე გამოსახულების მიკუთვნების განზოგადებით, ჩვენ შეგვიძლია მეტი ინფორმაცია მივიღოთ ამის შესახებ გენერაციული მოდელი გამოიყენება ღრმა ფეიკის შესაქმნელად, რომელიც სცილდება იმის აღიარებას, რომ ის არ არის ნანახი ადრე. და ღრმა ფეიქების კოლექციის ნიმუშებს შორის მსგავსების გამოკვლევით, ჩვენ ასევე შეგვიძლია ვთქვათ, წარმოიშვა თუ არა სურათების სერია. ერთი წყაროდან“, - წერენ მკვლევარებმა სი იინმა და ტან ჰასნერმა ფეისბუქის ბლოგ-პოსტში მისი ღრმა ყალბი აღმოჩენის შესახებ. მეთოდი.

ფეისბუქი

ვოლფრამი ამბობს, რომ ლოგიკურია, რომ გამოიყენებ მანქანურ სწავლებას მოწინავე ხელოვნური ინტელექტის მოდელის დასანახად (deepfake). თუმცა, ყოველთვის არის ადგილი ტექნოლოგიის მოტყუებისთვის.

„სულაც არ მიკვირს, რომ არსებობს მანქანური სწავლების წესიერი გზა [deepfakes-ის აღმოსაჩენად]“, თქვა ვოლფრამმა. „ერთადერთი კითხვაა, თუ საკმარის ძალისხმევას დახარჯავ, შეგიძლია მოატყუო? დარწმუნებული ვარ, რომ შეგიძლია.”

Deepfakes-თან ბრძოლა სხვა გზით

ამის ნაცვლად, ვოლფრამმა თქვა, რომ მას სჯერა, რომ ბლოკჩეინის გამოყენება საუკეთესო ვარიანტი იქნება გარკვეული ტიპის ღრმა ფეიკების ზუსტად გამოსავლენად. მისი აზრი ბლოკჩეინის გამოყენებასთან დაკავშირებით მანქანურ სწავლებაზე ბრუნდება 2019 წელს და მან თქვა, რომ საბოლოო ჯამში, ბლოკჩეინის მიდგომას შეუძლია უზრუნველყოს უფრო ზუსტი გადაწყვეტა ჩვენი ღრმა ფეიკის პრობლემის შესახებ.

„მოველით, რომ სურათებისა და ვიდეოს მაყურებლები რეგულარულად შეამოწმებენ ბლოკჩეინებს (და „მონაცემთა სამკუთხედს“ გამოთვლები') ცოტა ჰგავს იმას, თუ როგორ ამოწმებენ ახლა ვებ ბრაუზერები უსაფრთხოების სერთიფიკატებს“, - წერს ვოლფრამი სტატიაში გამოქვეყნებულია Scientific American-ში.

ვინაიდან ბლოკჩეინები ინახავს მონაცემებს ბლოკებში, რომლებიც შემდეგ ჯაჭვდება ერთმანეთთან ქრონოლოგიური თანმიმდევრობით, და ვინაიდან დეცენტრალიზებული ბლოკჩეინები უცვლელია, შეყვანილი მონაცემები შეუქცევადია.

„ერთადერთი კითხვაა, თუ საკმარის ძალისხმევას დახარჯავ, შეგიძლია მოატყუო? დარწმუნებული ვარ, რომ შეგიძლია."

ვოლფრამმა განმარტა, რომ ვიდეოს ბლოკჩეინში განთავსებით, თქვენ შეძლებთ ნახოთ მისი გადაღებული დრო, მდებარეობა და სხვა კონტექსტური ინფორმაცია, რომელიც საშუალებას მოგცემთ გითხრათ, შეცვლილია თუ არა გზა.

”ზოგადად, რაც უფრო მეტი მეტამონაცემებია, რომლებიც ასახავს სურათს ან ვიდეოს, მით უფრო სავარაუდოა, რომ თქვენ შეძლებთ ამის თქმას,” - თქვა მან. ”თქვენ არ შეგიძლიათ გააყალბოთ დრო ბლოკჩეინზე.”

თუმცა, ვოლფრამმა თქვა, რომ გამოყენებული მეთოდი - იქნება ეს მანქანური სწავლება თუ ბლოკჩეინის გამოყენება - დამოკიდებულია ღრმა ფეიკის ტიპზე, რომელსაც ცდილობთ დასაცავად (ანუ ვიდეო, სადაც კიმ კარდაშიანი ამბობს რაღაც სისულელეს, ან ვიდეო, სადაც პოლიტიკოსი აკეთებს განცხადებას ან წინადადება).

”ბლოკჩეინის მიდგომა იცავს გარკვეული სახის ღრმა გაყალბებისგან, ისევე როგორც მანქანური სწავლების სურათის დამუშავება იცავს გარკვეული სახის ღრმა ყალბებისგან,” - თქვა მან.

დედააზრი, როგორც ჩანს, არის სიფხიზლე ყველა ჩვენგანისთვის, როდესაც საქმე ეხება მომავალ ღრმა ცრუ წყალდიდობას.