AIは、動画を視聴することで動画を理解できるようになりました

- 研究者たちは、視聴することで動画にラベルを付けるようにAIに教えることができると言っています。

- AIシステムは、視覚データと音声データの間で共有される概念をキャプチャするためにデータを表現することを学習します。

- これは、人間が問題なく学習できるが、コンピューターは理解しにくいという概念を理解する方法をAIに教える取り組みの一環です。

茅野雄一郎/ゲッティイメージズ

新しい人工知能システム(AI)は、あなたのビデオを見たり聞いたりして、起こっていることにラベルを付けることができます。

MITの研究者は 技術を開発しました これは、ビデオとオーディオの間で共有されるアクションをキャプチャするようにAIに教えます。 たとえば、彼らの方法は、ビデオで泣いている赤ちゃんの行為が、サウンドクリップで話されている「泣いている」という言葉に関連していることを理解できます。 これは、人間が問題なく学習できるが、コンピューターは理解しにくいという概念を理解する方法をAIに教える取り組みの一環です。

「一般的な学習パラダイムである教師あり学習は、十分に説明され、完全なデータセットがある場合にうまく機能します」とAIエキスパート フィルワインダー メールインタビューでLifewireに語った。 「残念ながら、現実の世界には新しい状況を提示するという悪い習慣があるため、データセットが完全になることはめったにありません。」

よりスマートなAI

コンピューターは、人間のような音や画像ではなくデータを処理する必要があるため、日常のシナリオを理解するのが困難です。 マシンが写真を「見る」とき、画像分類などのタスクを実行するために使用できるデータにその写真をエンコードする必要があります。 AIは、入力がビデオ、オーディオクリップ、画像などの複数の形式で提供されると、行き詰まる可能性があります。

「ここでの主な課題は、マシンがこれらの異なるモダリティをどのように調整できるかということです。 人間として、これは私たちにとって簡単です。」 アレクサンダー劉MITの研究者であり、この主題に関する論文の筆頭著者である、はニュースリリースで述べています。 「私たちは車を見て、それから車が通り過ぎる音を聞きます、そして私たちはこれらが同じことであることを知っています。 しかし、機械学習の場合、それはそれほど単純ではありません。」

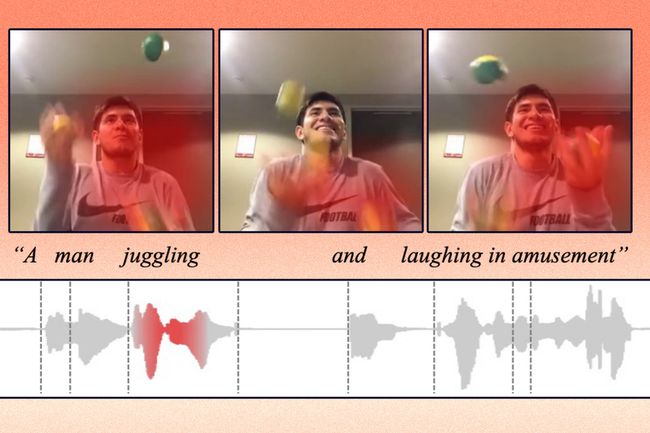

Liuのチームは、視覚データと音声データの間で共有される概念をキャプチャするためにデータを表現することを学ぶというAI技術を開発しました。 この知識を使用して、彼らの機械学習モデルは、特定のアクションがビデオのどこで行われているのかを識別し、それにラベルを付けることができます。

新しいモデルは、ビデオやそれに対応するテキストキャプションなどの生データを取得し、ビデオ内のオブジェクトやアクションに関する特徴や観察結果を抽出することでそれらをエンコードします。 次に、これらのデータポイントをグリッドにマッピングします。これは埋め込みスペースと呼ばれます。 モデルは、類似したデータをグリッド内の単一のポイントとしてクラスター化します。 これらの各データポイントまたはベクトルは、個々の単語で表されます。

たとえば、ジャグリングをしている人のビデオクリップは、「ジャグリング」というラベルの付いたベクトルにマッピングされる場合があります。

研究者は、ベクトルのラベル付けに1,000語しか使用できないようにモデルを設計しました。 モデルは、単一のベクトルにエンコードするアクションまたは概念を決定できますが、使用できるのは1,000個のベクトルのみです。 モデルは、データを最もよく表すと思われる単語を選択します。

「豚に関する動画がある場合、モデルは「豚」という単語を1,000個のベクトルの1つに割り当てる可能性があります。 次に、モデルがオーディオクリップで「豚」という単語を言うのを聞いた場合でも、同じベクトルを使用してそれをエンコードする必要があります」とLiu氏は説明しました。

あなたのビデオ、デコード

MITによって開発されたようなより良いラベリングシステムは、AIのバイアスを減らすのに役立つ可能性があります。 マリアン・ベゼデスバイオメトリクス会社Innovatricsの研究開発責任者は、電子メールのインタビューでLifewireに語った。 Beszedesは、データ業界が製造プロセスの観点からAIシステムを見ることができると示唆しました。

「システムは生データを入力(原材料)として受け入れ、前処理し、取り込み、意思決定または予測を行い、分析(完成品)を出力します」とBeszedes氏は述べています。 「このプロセスフローを「データファクトリ」と呼びます。他の製造プロセスと同様に、品質管理の対象となる必要があります。 データ業界は、AIバイアスを品質の問題として扱う必要があります。

「消費者の観点からすると、誤ったラベルのデータは、たとえば特定の画像/ビデオのオンライン検索をより困難にします」とBeszedes氏は付け加えました。 「正しく開発されたAIを使用すると、手動のラベル付けよりもはるかに高速で中立的なラベル付けを自動的に行うことができます。」

MITニュース

しかし、MITモデルにはまだいくつかの制限があります。 一つには、彼らの研究は一度に2つのソースからのデータに焦点を合わせていましたが、現実の世界では、人間は同時に多くの種類の情報に遭遇します、とLiuは言いました。

「この種のデータセットでは1,000語が機能することはわかっていますが、実際の問題に一般化できるかどうかはわかりません」とLiu氏は付け加えました。

MITの研究者は、彼らの新しい技術が多くの同様のモデルよりも優れていると述べています。 AIをトレーニングして動画を理解できるようになれば、最終的には友人の休暇の動画の視聴をスキップして、代わりにコンピューターで生成されたレポートを取得できる可能性があります。