IOS15.2ヌード検出はオンデバイスおよびオプトインになります

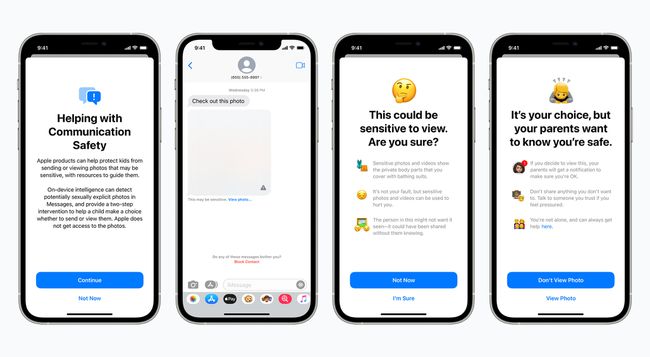

Appleは、iOS 15.2のメッセージアプリでヌードを検出する児童保護機能を推進しますが、保護者はそれをオンにする必要があります。

Appleが最初にその児童保護機能を明らかにしたとき、彼らは かなり批判的な対応, その結果、計画された展開が遅れます. プライバシーに関する最大の懸念事項であるAppleによる児童性的虐待資料(CSAM)のiCloud写真のスキャンはまだ保留中ですが、 ブルームバーグ、メッセージアップデートはiOS15.2でリリースされる予定です。 ただし、Appleによると、デフォルトではオンにならないという。 その画像分析はデバイス上で行われるため、機密性の高い可能性のあるものにアクセスすることはできません 材料。

RF画像/ゲッティイメージズ

Appleによると、有効にすると、この機能はデバイス上の機械学習を使用して、メッセージで送信または受信した写真に露骨な内容が含まれているかどうかを検出します。 これにより、明示的な可能性のある着信画像がぼやけ、子供に警告したり、明示的なものを送信している場合は警告を表示したりします。

どちらの場合も、子供は親に連絡して何が起こっているのかを伝えるオプションもあります。 のリストで よくある質問、Appleは、12歳以下の子供アカウントの場合、明示的な資料を表示/送信すると親に連絡することを子供に警告すると述べています。 13〜17歳の子供のアカウントの場合、子供は潜在的なリスクについて警告されますが、親には連絡されません。

アップル

同じFAQで、Appleは、Apple、法執行機関、NCMEC(National Center for Missing&Exploited Children)などの外部の関係者と情報が共有されることはないと主張しています。

メッセージのこれらの新しい子供の安全オプションは、次のiOS15.2アップデートで利用可能になるはずです。 今月中に転がる予定です、 によると Macworld.