TensorRT-LLM מביאה מחשוב AI מקומי למעבדי NVIDIA GPU

מה שאתה צריך לדעת

- TensorRT-LLM מוסיפה את תמיכת Chat API של OpenAI עבור מחשבים נייחים ומחשבים ניידים עם RTX GPUs החל מ-8GB של VRAM.

- משתמשים יכולים לעבד שאילתות LLM מהר יותר ומקומי מבלי להעלות מערכי נתונים לענן.

- NVIDIA מצמידה את זה ל-"Retrieval-Augmented Generation" (RAG), ומאפשרת יותר מקרי שימוש ב-LLM מותאמים אישית.

במהלך כנס Ignite של מיקרוסופט היום, NVIDIA הכריזה על עדכון ל-TensorRT-LLM שלהם, אשר הושק באוקטובר. ההכרזות העיקריות היום הן שתכונת TensorRT-LLM זוכה כעת לתמיכה עבור ממשקי API של LLM, במיוחד OpenAI Chat API, שהוא הכי הרבה ידועים בשלב זה, וגם שהם עבדו לשיפור הביצועים עם TensorRT-LLM כדי לקבל ביצועים טובים יותר לכל אסימון במעבדי ה-GPU שלהם.

יש הודעה שלישונית שהיא גם מעניינת למדי. NVIDIA הולכת לכלול את דור האחזור המוגבר עם ה-TensorRT-LLM. זה מאפשר ל-LLM להשתמש במקור נתונים חיצוני עבור בסיס הידע שלו במקום להסתמך על כל דבר מקוון - תכונה מבוקשת מאוד עבור AI.

מה זה TensorRT-LLM?

קרא עוד מ-IGNITE 2023

- מיקרוסופט מייצרת שבבי Arm משלה

- Copilot מגיע לכל Microsoft 365

- Bing Chat מיתוג מחדש ל-Copilot

- Microsoft Loop זמין כעת באופן כללי

- Microsoft Mesh ו-Immersive Spaces

- Microsoft Planner ממזג את To Do ו- Project

- מיקרוסופט משיקה את Copilot Studio

- Microsoft Security Copilot

- אפליקציית האינטרנט Copilot עולה לאוויר

NVIDIA השיקה לאחרונה את NVIDIA TensorRT-LLM, ספריית קוד פתוח המאפשרת מחשוב מקומי של LLMs על חומרת NVIDIA. NVIDIA מציגה זאת כדי להשיג פרטיות ויעילות בעת התמודדות עם מערכי נתונים גדולים או מידע פרטי. האם המידע הזה נשלח דרך API כמו Chat API של OpenAI היא מאובטחת. תוכל ללמוד עוד על NVIDIA TensorRT-LLM בכתובת אתר המפתחים של NVIDIA.

השינויים שהוכרזו היום ל-NVIDIA TensorRT-LLM הם תוספת של ה-Chat API והביצועים של OpenAI שיפורים עבור LLMs ודגמי AI שנתמכו בעבר כמו Llama 2 ו-Stable Diffusion באמצעות DirectML שיפורים.

טכנולוגיה זו ומחשוב יכולים להיעשות באופן מקומי באמצעות שולחן העבודה של AI של NVIDIA. "ערכת הכלים המאוחדת והקלה לשימוש מאפשרת למפתחים ליצור במהירות, לבדוק ולהתאים אישית דגמי בינה מלאכותית מחוללת ו-LLM על מחשב או תחנת עבודה". ל-NVIDIA יש דף הרשמה לגישה מוקדמת למעוניינים להשתמש בו.

NVIDIA TensorRT-LLM היא ספריית קוד פתוח שמאיצה וממטבת את ביצועי ההסקה של דגמי השפות הגדולות העדכניות ביותר (LLMs) בפלטפורמת NVIDIA AI

NVIDIA

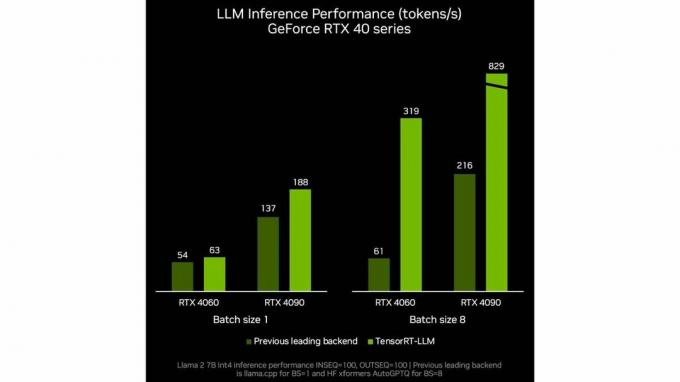

Nvidia מציגה גם שיפור בביצועים לכל אסימון עבור LLMs כפי שאנו יכולים לראות במדדי NVIDIA פנימיים אלה. כמו תמיד, היזהר ממדדי היצרן ומבדיקות לדיווח מדויק על רווחי ביצועים.

עכשיו כשאנחנו מכירים את TensorRT-LLM של NVIDIA, למה זה מיוחד או שימושי? לרוב, ריצה מקומית על תחנת עבודה או מחשב המופעלים על ידי NVIDIA תביא כנראה לאותן תשובות לשאילתות, אם כי ככל הנראה בקצב איטי יותר בגלל היעדר כוח מחשוב ענן.

התמונה של NVIDIA למקרה שימוש זה מתכנסת כאשר דנים בהכרזה האחרת היום מ NVIDIA, כלומר השילוב עם טכנולוגיה או תכונה חדשה בשם Retrieval-Augmented דוֹר.

מהו דור אחזור מוגדל

המונח דור מוגבר של אחזור נטבע ב-a עיתון מאת סדרה של סופרים, כאשר המחבר הראשי הוא פטריק לואיס. זה השם שמאומץ על ידי התעשייה לפתרון בעיה שכל מי שהשתמש ב-LLM נתקל בה. לא מעודכן או מידע נכון אך שגוי בהקשר של הדיון. ניתן למצוא את הפרטים המעמיקים של אופן הפעולה של RAG באחד מ-NVIDIA תקצירים טכניים.

דור מוגבר של אחזור הוא טכניקה לשיפור הדיוק והאמינות של מודלים של בינה מלאכותית עם עובדות שנאספו ממקורות חיצוניים.

ריק מריט

על ידי התאמה של דור אחזור מוגבר עם TensorRT-LLM של NVIDIA, משתמשי קצה יכולים להתאים אישית לאיזה מידע ל-LLM יש גישה כשהוא מפעיל את השאילתות שלו. ChatGPT הכריז לאחרונה GPTs מותאמים אישית שיכולות להציע תוצאות דומות.

כפי שנדון במאמר שלנו סביב GPTs מותאמים אישית, היכולת ליצור מופעי LLM מותאמים אישית, חד-תכליתיים עם GPT מותאם אישית או, במקרה זה, מופע LLM אשר באמצעות דור מוגבר אחזור, בעל גישה רק לכל היצירות שפורסמו של צ'רלס דיקנס ותו לא, יוכל לסייע ביצירת תכניות לימודים בעלות משמעות, משמעות ומדויקת עבור מקרי שימוש שונים.

האם TensorRT-LLM יהיה שימושי?

מה זה אומר הכל ביחד? יש כמה הזדמנויות אמיתיות לשימוש זה בצורה משמעותית. כמה קל יהיה ליישם, או כמה בטוח יהיו הנתונים? רק הזמן יגיד. יש כאן פוטנציאל לשיפורי AI, במיוחד ברמת הארגון תהליכי עבודה, מציעים גישה נוחה יותר למידע מסובך, ומסייעים לעובדים עם משימות מאתגרות.

למרות שהמשימות הללו יופעלו באופן מקומי, הן עדיין יעברו את ממשקי ה- LLM הרגילים, שיתמודדו עם אותן הגבלות ומגבלות תוכן שהם עומדים בפניהם כעת. עם זאת, מכיוון שטכנולוגיות כמו TensorRT-LLM של NVIDIA הופכות את השימוש ב-LLM במצב לא מקוון מהיר יותר, מישהו יכול לשלב אותו עם משהו כמו EvilGPT, שאין לה מגבלות על התנהלותה והיא משמשת כיום ליצירת תוכנות זדוניות וסיוע בהתקפות סייבר, הפוטנציאל של AI לבצע נזק אמיתי רק מתגבר.

מה אתה חושב על העדכונים של NVIDIA ל-TensorRT-LLM? אתה יכול לחשוב על שימושים כלשהם שפספסתי לו? ספר לנו בתגובות.