הטכנולוגיה Deepfake של פייסבוק לא תציל אותנו, אומרים מומחים

- ככל שהזיופים העמוקים הופכים לקלים יותר להכנה, דרכים חדשות ומשופרות לאיתור אותם הפכו בראש סדר העדיפויות.

- טכנולוגיית זיהוי הזיוף העמוק של פייסבוק משתמשת בלמידה חישובית הפוכה כדי לגלות אם הסרטון הוא זיוף עמוק או לא.

- מומחים אומרים ששימוש בטכנולוגיית בלוקצ'יין תהיה הדרך הטובה ביותר לראות אם סרטון וידאו אמיתי או לא, מכיוון שהשיטה מסתמכת על נתונים הקשריים.

Getty Images

פייסבוק בטוחה בכך מודל למידת מכונה למלחמה בזיופים עמוקים, אבל מומחים טוענים שלמידת מכונה בפני עצמה לא תציל אותנו מזיופים עמוקים.

חברות כמו פייסבוק, מיקרוסופט וגוגל כולם עובדים כדי להילחם בזיופים עמוקים מהתפשטות ברחבי האינטרנט והרשתות החברתיות. אמנם השיטות שונות, אבל יש שיטה אחת פוטנציאלית חסינת שטויות לזהות את הסרטונים השקריים האלה: בלוקצ'יין.

"[Blockchains] פשוט נותנים לך המון פוטנציאל לאמת את הזיוף העמוק בצורה שהיא צורת האימות הטובה ביותר שאני יכול לראות", סטיבן וולפרם, מייסד ומנכ"ל מחקר וולפרם ומחבר של סוג חדש של מדע, אמר ל-Lifewire בטלפון.

טכנולוגיית Deepfake-Spotting של פייסבוק

טכנולוגיית Deepfake גדלה במהירות במהלך השנים האחרונות. הסרטונים המטעים משתמשים בשיטות למידת מכונה כדי לעשות דברים כמו הנחת פנים של מישהו על גופו של אדם אחר, שינוי תנאי רקע, זיוף שפתיים ועוד. הם נעים בין פרודיות לא מזיקות ועד לגרום לסלבריטאים או אישי ציבור לומר או לעשות משהו שהם לא עשו.

מומחים אומרים שהטכנולוגיה מתקדמת במהירות, ושזיופים עמוקים רק יהיו משכנעים יותר (וקלים יותר ליצירה) ככל שהטכנולוגיה תהיה זמינה יותר ויותר חדשנית.

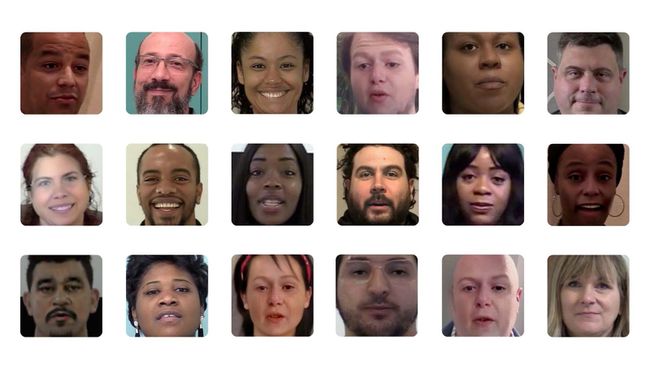

ApolitikNow / Flickr / CC By 2.0

פייסבוק נתנה לאחרונה תובנה נוספת לגבי טכנולוגיית זיהוי הזיוף העמוק שלה בשיתוף עם אוניברסיטת מישיגן סטייט. הרשת החברתית אומרת שהיא מסתמכת על הנדסה הפוכה מתמונה אחת שנוצרת בבינה מלאכותית ועד למודל הגנרטיבי המשמש לייצורה.

מדענים שעבדו עם פייסבוק אמרו שהשיטה מסתמכת על חשיפת הדפוסים הייחודיים מאחורי מודל הבינה המלאכותית המשמש ליצירת זיוף עמוק.

"על ידי הכללת ייחוס תמונה לזיהוי בסט פתוח, נוכל להסיק מידע נוסף על מודל יצירתי המשמש ליצירת זיוף עמוק שמעבר להכרה בכך שהוא לא נראה לפני. ועל ידי התחקות אחר קווי דמיון בין דפוסים של אוסף של זיופים עמוקים, נוכל גם לדעת אם נוצרה סדרה של תמונות ממקור יחיד", כתבו מדעני המחקר שי ין וטאן הסנר בפוסט בבלוג של פייסבוק על איתור הזיוף העמוק שלו. שיטה.

פייסבוק

וולפרם אומר שזה הגיוני שתשתמש בלמידת מכונה כדי לזהות מודל AI מתקדם (זיוף עמוק). עם זאת, תמיד יש מקום לשטות בטכנולוגיה.

"אני בכלל לא מופתע שיש דרך הגונה של למידת מכונה [זיהוי זיופים עמוקים]", אמר וולפרם. "השאלה היחידה היא אם אתה מתאמץ מספיק, האם אתה יכול לרמות את זה? אני בטוח שאתה יכול."

נלחמים בדיפפייקס בדרך אחרת

במקום זאת, וולפרם אמר שהוא מאמין ששימוש בבלוקצ'יין יהיה האפשרות הטובה ביותר לאתר במדויק סוגים מסוימים של זיופים עמוקים. דעתו על שימוש בבלוקצ'יין על פני למידת מכונה חוזרת ל-2019, והוא אמר שבסופו של דבר, גישת הבלוקצ'יין יכולה לספק פתרון מדויק יותר לבעיית הזיוף העמוק שלנו.

"הייתי מצפה שצופי תמונות וסרטונים יוכלו לבדוק באופן שגרתי מול בלוקצ'יין (ו'טריאנגולציית נתונים' חישובים') קצת כמו איך דפדפני אינטרנט בודקים כעת אישורי אבטחה", כתב וולפרם במאמר פורסם ב-Scientific American.

מכיוון ש- blockchains מאחסנים נתונים בבלוקים אשר משורשרים זה לזה בסדר כרונולוגי, ומכיוון ש- blockchains מבוזר הם בלתי ניתנים לשינוי, הנתונים שהוזנו הם בלתי הפיכים.

"השאלה היחידה היא אם אתה מתאמץ מספיק, אתה יכול לרמות את זה? אני בטוח שאתה יכול."

וולפרם הסביר שעל ידי הכנסת סרטון לבלוקצ'יין, תוכל לראות את הזמן שבו הוא צולם, המיקום ומידע הקשרי אחר שיאפשר לך לדעת אם הוא השתנה במשהו דֶרֶך.

"באופן כללי, ככל שיש יותר מטא נתונים שמקשרים את התמונה או הסרטון, כך גדל הסיכוי שתצליח לדעת", אמר. "אי אפשר לזייף זמן בבלוקצ'יין."

עם זאת, וולפרם אמר שהשיטה שבה נעשה שימוש - בין אם זו למידת מכונה או שימוש בבלוקצ'יין - תלויה בסוג הזיוף העמוק שאתה מנסה להגן מפני (כלומר, סרטון של קים קרדשיאן אומרת משהו טיפשי או סרטון של פוליטיקאי שמשמיע הצהרה או הַצָעָה).

"גישת הבלוקצ'יין מגינה מפני סוגים מסוימים של זיופים עמוקים, בדיוק כפי שעיבוד תמונה למידת מכונה מגן מפני סוגים מסוימים של זיופים עמוקים", אמר.

השורה התחתונה, כך נראה, היא ערנות לכולנו בכל הנוגע למאבק במבול הזיוף העמוק הקרוב.