TensorRT-LLM porta l'elaborazione IA locale sulle GPU NVIDIA

Cosa hai bisogno di sapere

- TensorRT-LLM aggiunge il supporto dell'API Chat di OpenAI per desktop e laptop con GPU RTX a partire da 8 GB di VRAM.

- Gli utenti possono elaborare le query LLM più velocemente e localmente senza caricare set di dati nel cloud.

- NVIDIA abbina questo a "Retrieval-Augmented Generation" (RAG), consentendo casi d'uso LLM più personalizzati.

Durante la conferenza Ignite di Microsoft, NVIDIA ha annunciato un aggiornamento del suo TensorRT-LLM, che lanciato in ottobre. Gli annunci principali di oggi riguardano che la funzionalità TensorRT-LLM sta ora ottenendo il supporto per le API LLM, in particolare l'API OpenAI Chat, che è la più ben noto a questo punto e anche che hanno lavorato per migliorare le prestazioni con TensorRT-LLM per ottenere prestazioni migliori per token sulle loro GPU.

C'è anche un annuncio terziario che è piuttosto interessante. NVIDIA includerà la Retrieval-Augmented Generation con TensorRT-LLM. Ciò consente a un LLM di utilizzare un'origine dati esterna per la propria base di conoscenza anziché fare affidamento su qualsiasi cosa online, una funzionalità molto richiesta per l'intelligenza artificiale.

Cos'è TensorRT-LLM?

LEGGI DI PIÙ DA IGNITE 2023

- Microsoft sta producendo i propri chip Arm

- Copilot è disponibile in tutto Microsoft 365

- Bing Chat è stato rinominato Copilot

- Microsoft Loop è ora disponibile a livello generale

- Microsoft Mesh e spazi immersivi

- Microsoft Planner unisce To Do e Project

- Microsoft lancia Copilot Studio

- Copilota di sicurezza Microsoft

- L'app Web Copilot è attiva

NVIDIA ha recentemente lanciato NVIDIA TensorRT-LLM, una libreria open source che consente l'elaborazione locale di LLM su hardware NVIDIA. NVIDIA lo pubblicizza per ottenere privacy ed efficienza quando si tratta di set di dati di grandi dimensioni o informazioni private. Il fatto che tali informazioni vengano inviate tramite un'API come l'API Chat di OpenAI è sicuro. Puoi saperne di più su NVIDIA TensorRT-LLM su Il sito degli sviluppatori NVIDIA.

Le modifiche annunciate oggi a NVIDIA TensorRT-LLM riguardano l'aggiunta dell'API Chat e delle prestazioni di OpenAI miglioramenti per LLM e modelli AI precedentemente supportati come Llama 2 e Stable Diffusion tramite DirectML miglioramenti.

Questa tecnologia e l'informatica possono essere eseguite localmente Il banco di lavoro AI di NVIDIA. Questo "toolkit unificato e facile da usare consente agli sviluppatori di creare, testare e personalizzare rapidamente modelli di intelligenza artificiale generativa e LLM pre-addestrati su un PC o una workstation". NVIDIA ha un pagina di registrazione ad accesso anticipato per chi fosse interessato ad usarlo.

NVIDIA TensorRT-LLM è una libreria open source che accelera e ottimizza le prestazioni di inferenza degli ultimi Large Language Model (LLM) sulla piattaforma NVIDIA AI

NVIDIA

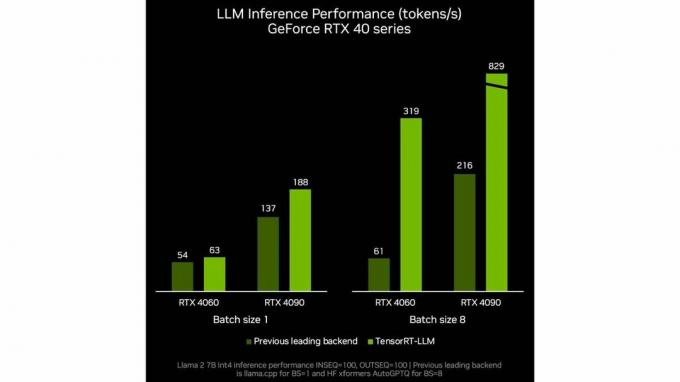

Nvidia sta anche mostrando un miglioramento delle prestazioni per token per gli LLM, come possiamo vedere in questi benchmark interni di NVIDIA. Come sempre, diffidare dei benchmark e dei test del produttore per ottenere rapporti accurati sul miglioramento delle prestazioni.

Ora che conosciamo TensorRT-LLM di NVIDIA, perché è speciale o utile? Nella maggior parte dei casi, l'esecuzione locale su una workstation o un PC basato su NVIDIA darà probabilmente le stesse risposte alle domande, anche se probabilmente a un ritmo più lento a causa della mancanza di potenza del cloud computing.

L'immagine di NVIDIA per questo caso d'uso si delinea quando si discute dell'altro annuncio di oggi NVIDIA, ovvero l'integrazione con una nuova tecnologia o funzionalità chiamata Retrieval-Augmented Generazione.

Cos'è la generazione aumentata con recupero

Il termine generazione aumentata con recupero è stato coniato in a carta da una serie di autori, con l'autore principale Patrick Lewis. È il nome adottato dall'industria per una soluzione a un problema riscontrato da tutti coloro che hanno utilizzato un LLM. Informazioni non aggiornate o corrette ma errate nel contesto della discussione. I dettagli approfonditi su come funziona RAG possono essere trovati in uno dei prodotti NVIDIA Brief tecnici.

La generazione aumentata con recupero è una tecnica per migliorare l'accuratezza e l'affidabilità dei modelli di intelligenza artificiale generativa con fatti recuperati da fonti esterne.

Rick Merritt

Associando la generazione aumentata di recupero con TensorRT-LLM di NVIDIA, gli utenti finali possono personalizzare le informazioni a cui LLM ha accesso quando esegue le query. ChatGPT recentemente annunciato GPT personalizzati che potrebbe offrire risultati simili.

Come discusso nel nostro articolo sui GPT personalizzati, la possibilità di creare istanze LLM personalizzate e monouso con un GPT personalizzato o, in questo caso, un'istanza LLM che, utilizzando generazione aumentata di recupero, ha accesso solo a tutte le opere pubblicate di Charles Dickens e nient'altro, potrebbe aiutare a creare LLM mirati, significativi e accurati per diversi casi d'uso.

TensorRT-LLM sarà utile?

Cosa significa tutto questo insieme? Ci sono alcune reali opportunità affinché questo possa essere utilizzato in modo significativo. Quanto sarà facile implementarlo o quanto saranno sicuri i dati? Solo il tempo lo dirà. In questo caso esiste il potenziale per miglioramenti dell’intelligenza artificiale, soprattutto a livello aziendale flussi di lavoro, offrono un accesso più conveniente a informazioni complesse e assistono i dipendenti compiti impegnativi.

Anche se queste attività verranno eseguite localmente, passeranno comunque attraverso le normali API LLM, che dovranno affrontare le stesse restrizioni e limitazioni sui contenuti che si trovano ora. Tuttavia, poiché tecnologie come TensorRT-LLM di NVIDIA rendono più veloce l'utilizzo di un LLM offline, qualcuno potrebbe integrarlo con qualcosa di simile EvilGPT, che non ha limitazioni nella sua condotta ed è attualmente utilizzato per creare malware e assistere negli attacchi informatici, il potenziale per un'intelligenza artificiale che esegue danni reali non fa altro che amplificarsi.

Cosa ne pensi degli aggiornamenti di NVIDIA a TensorRT-LLM? Riesci a pensare a qualche utilizzo che mi sono perso? Fateci sapere nei commenti.