Facebookova tehnologija Deepfake nas neće spasiti, kažu stručnjaci

- Kako deepfake postaje lakše napraviti, novi i poboljšani načini njihovog uočavanja postali su prioritet.

- Facebookova tehnologija za uočavanje dubokog lažiranja koristi obrnuto strojno učenje kako bi otkrila je li video lažan ili nije.

- Stručnjaci kažu da bi korištenje blockchain tehnologije bio najbolji način da se vidi je li video stvaran ili ne jer se metoda oslanja na kontekstualne podatke.

Getty Images

Facebook je siguran u svoje model strojnog učenja za borbu protiv deepfakesa, ali stručnjaci kažu da nas strojno učenje samo po sebi neće spasiti od prevare deepfakesa.

Tvrtke poput Facebooka, Microsofta i Googlea svi rade na borbi protiv deepfakesa od širenja internetom i društvenim mrežama. Iako se metode razlikuju, postoji jedna potencijalno sigurna metoda za uočavanje ovih lažnih videozapisa: blockchains.

“[Blockchains] vam samo daju puno potencijala da potvrdite deepfake na način koji je najbolji oblik provjere koji mogu vidjeti”, Stephen Wolfram, osnivač i izvršni direktor Wolfram Research i autor Nova vrsta znanosti, rekao je za Lifewire preko telefona.

Facebookova tehnologija Deepfake-Spotting

Deepfake tehnologija je brzo rasla u posljednjih nekoliko godina. Obmanjujući videozapisi koriste metode strojnog učenja kako bi učinili stvari kao što su namještanje nečijeg lica na tijelo druge osobe, izmjena pozadinskih uvjeta, lažna sinkronizacija usana i još mnogo toga. Oni se kreću od bezazlenih parodija do natjeravanja slavnih ili javnih osoba da kažu ili učine nešto što nisu.

Stručnjaci kažu da tehnologija brzo napreduje i da će deepfakes postati uvjerljiviji (i lakši za kreiranje) kako tehnologija postaje sve dostupnija i inovativnija.

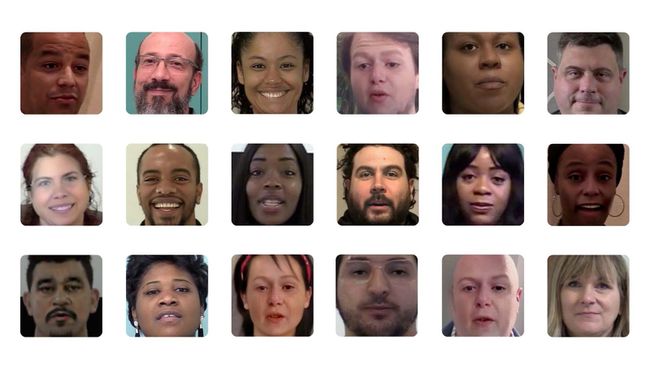

ApolitikNow / Flickr / CC By 2.0

Facebook je nedavno dao više uvida u svoju tehnologiju otkrivanja deepfake u partnerstvu sa Sveučilištem Michigan State. Društvena mreža kaže da se oslanja na obrnuti inženjering od jedne slike generirane umjetnom inteligencijom do generativnog modela koji se koristi za njegovu proizvodnju.

Znanstvenici koji su radili s Facebookom rekli su da se metoda oslanja na otkrivanje jedinstvenih obrazaca iza AI modela koji se koristi za generiranje deepfakea.

“Uopćavanjem atribucije slike na prepoznavanje otvorenog skupa, možemo zaključiti više informacija o generativni model koji se koristi za stvaranje deepfakea koji nadilazi prepoznavanje da nije viđen prije. A praćenjem sličnosti među uzorcima zbirke deepfakesa, također bismo mogli utvrditi je li niz slika nastao iz jednog izvora”, napisali su znanstvenici Xi Yin i Tan Hassner na Facebookovom blogu o njegovom deepfake-spottingu metoda.

Wolfram kaže da ima smisla koristiti strojno učenje da uočite napredni AI model (deepfake). Međutim, uvijek postoji prostor za zavaravanje tehnologije.

“Uopće nisam iznenađen što postoji pristojan način strojnog učenja za [otkrivanje deepfakesa]”, rekao je Wolfram. “Jedino je pitanje, ako uložiš dovoljno truda, možeš li ga prevariti? Siguran sam da možeš.”

Borba protiv Deepfakesa na drugačiji način

Umjesto toga, Wolfram je rekao da vjeruje da bi korištenje blockchaina bila najbolja opcija za precizno uočavanje određenih vrsta deepfakea. Njegovo mišljenje o korištenju blockchaina u odnosu na strojno učenje seže do 2019. godine i rekao je da, u konačnici, blockchain pristup može pružiti točnije rješenje za naš deepfake problem.

“Očekivao bih da bi gledatelji slika i videa mogli rutinski provjeravati u odnosu na blockchaine (i 'triangulaciju podataka computations') pomalo nalik na to kako web preglednici sada provjeravaju sigurnosne certifikate”, napisao je Wolfram u članku objavljeno u Scientific American.

Budući da lanci blokova pohranjuju podatke u blokove koji se zatim povezuju zajedno kronološkim redoslijedom i budući da su decentralizirani lanci blokova nepromjenjivi, uneseni podaci su nepovratni.

„Jedino je pitanje, ako se dovoljno potrudiš, možeš li to prevariti? Siguran sam da možeš."

Wolfram je objasnio da stavljanjem videa u blockchain možete vidjeti vrijeme snimanja, lokaciju i druge kontekstualne informacije koje bi vam omogućile da utvrdite je li bilo promijenjeno put.

"Općenito, što više metapodataka postoji koji kontekstualiziraju sliku ili video, veća je vjerojatnost da ćete to moći reći", rekao je. “Ne možete lažirati vrijeme na blockchainu.”

Međutim, Wolfram je rekao da korištena metoda - bilo da se radi o strojnom učenju ili korištenju blockchaina - ovisi o vrsti deepfakea koji pokušavate zaštititi od (tj. videa na kojem Kim Kardashian govori nešto glupo ili videa političara koji daje izjavu ili prijedlog).

"Blockchain pristup štiti od određenih vrsta dubokih lažiranja, baš kao što obrada slika strojnog učenja štiti od određenih vrsta dubokih lažiranja", rekao je.

Zaključak je, čini se, budnost svih nas kada je u pitanju suzbijanje nadolazeće lažne poplave.